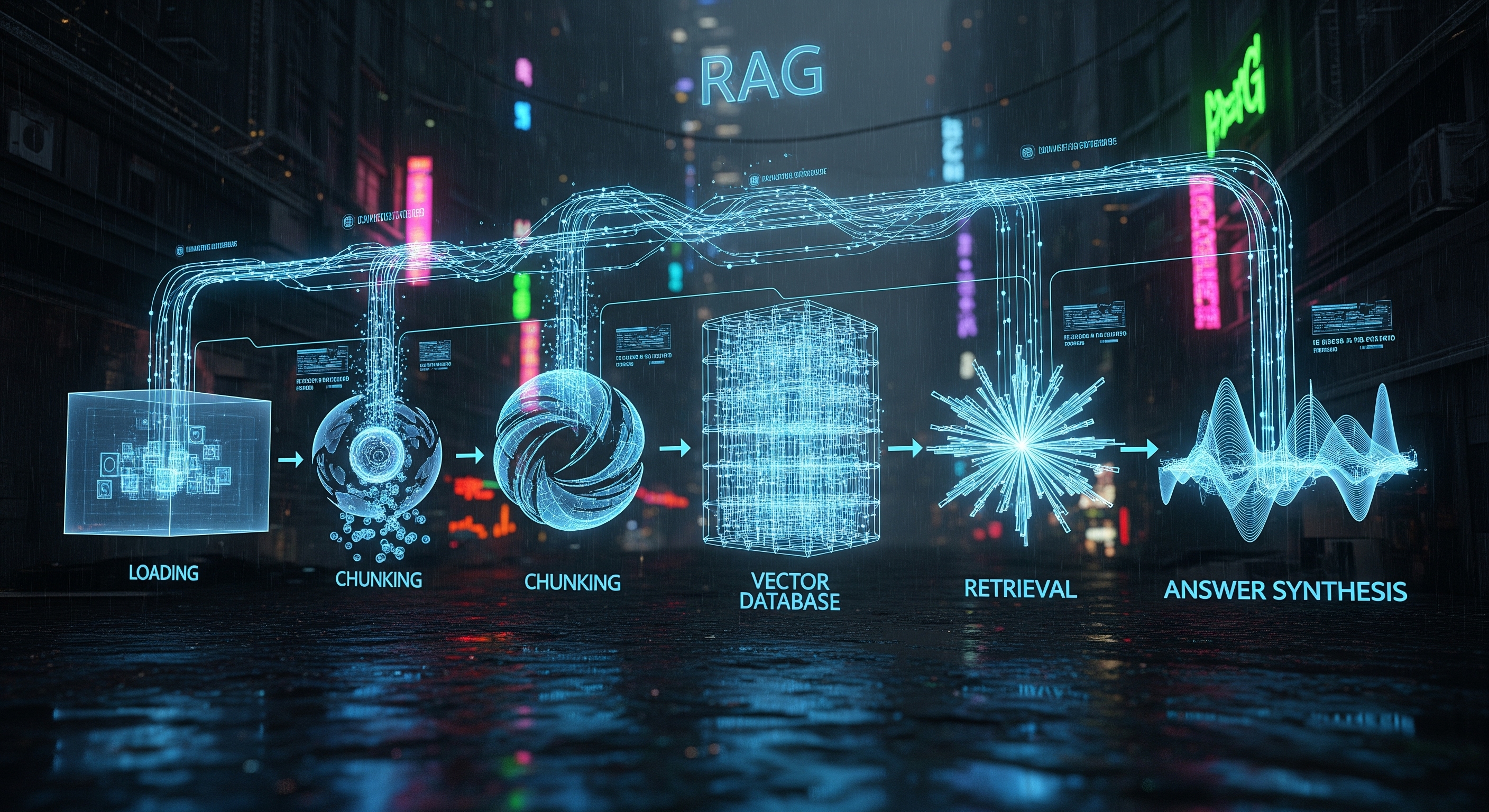

Étape 1 : Chargement et Fragmentation (Loading and Chunking) 쪼개기

Pour commencer, vous devez fournir vos données au système. C'est l'étape de chargement (loading). Les données peuvent provenir de n'importe où : PDF, documents Word, sites web, une base de données Notion, ou même un canal Slack. Le pipeline ingère ces données brutes et non structurées.

Cependant, les LLM ont une fenêtre de contexte limitée — ils ne peuvent traiter qu'une certaine quantité d'informations à la fois. Vous ne pouvez pas simplement insérer un manuel de 500 pages dans le prompt. C'est là que la fragmentation (chunking) intervient. Les données chargées sont divisées stratégiquement en morceaux plus petits et gérables, appelés "chunks". Il ne s'agit pas d'une découpe aléatoire ; une fragmentation efficace préserve le sens sémantique du texte, souvent en le divisant en paragraphes ou en sections.

-

Objectif : Ingérer des données brutes et les diviser en morceaux significatifs et digestes pour le traitement.

Étape 2 : L'Indexation : Bienvenue aux Bases de Données Vectorielles ! 🗂️

Une fois vos données fragmentées, le système a besoin d'un moyen de les comprendre et de les organiser. C'est l'étape d'indexation, et c'est là que le "vecteur" dans "base de données vectorielle" devient crucial.

Chaque fragment de texte est converti en une représentation numérique appelée plongement vectoriel (vector embedding). Pensez-y comme une empreinte digitale numérique sophistiquée. Un modèle de plongement (un réseau de neurones spécialisé) lit un fragment de texte et capture sa signification sémantique sous la forme d'une liste de nombres (un vecteur). Les fragments ayant des significations similaires auront des vecteurs "proches" les uns des autres dans l'espace mathématique.

Ces vecteurs sont ensuite stockés dans une base de données spécialisée conçue exactement à cet effet : une base de données vectorielle. Cette base de données est hautement optimisée pour stocker et rechercher des millions, voire des milliards de ces vecteurs à des vitesses incroyables.

-

Objectif : Convertir les fragments de texte en vecteurs numériques (plongements) et les stocker dans une base de données vectorielle interrogeable.

Étape 3 : La Récupération : Trouver le Bon Contexte 🔍

Maintenant, disons que vous posez une question, comme : "Quels étaient nos revenus du T2 en Europe ?" C'est ici que la "Récupération" (Retrieval) du RAG entre en jeu.

Votre requête est également convertie en un plongement vectoriel en utilisant le même modèle. Le système RAG utilise ensuite ce vecteur de requête pour effectuer une recherche dans la base de données vectorielle. Il effectue une recherche par similarité (souvent en utilisant un algorithme comme la similarité cosinus) pour trouver les fragments de texte dont les vecteurs sont les plus proches du vecteur de votre requête.

Le résultat est une liste classée des fragments de texte les plus pertinents de vos documents originaux. Il ne s'agit pas seulement de correspondances de mots-clés ; ce sont des fragments qui sont sémantiquement liés à votre question. C'est le contexte crucial dont le LLM a besoin pour formuler une réponse précise.

-

Objectif : Prendre la requête de l'utilisateur, la convertir en vecteur et récupérer les fragments d'information les plus pertinents de la base de données vectorielle.

Étape 4 : La Synthèse : Générer la Réponse Finale ✨

Une fois le contexte le plus pertinent récupéré, nous arrivons à la dernière étape : la synthèse de la réponse.

Le pipeline RAG prend votre requête originale et les fragments de texte récupérés et les regroupe dans un nouveau prompt augmenté pour le LLM. Le prompt dit essentiellement : "En utilisant les informations suivantes, veuillez répondre à cette question."

-

Requête originale : "Quels étaient nos revenus du T2 en Europe ?"

-

Contexte récupéré : [Fragment 1 : "Le rapport financier du T2 montre des revenus européens de 5,4 M€...", Fragment 2 : "Le résumé des opérations européennes souligne une croissance de 15% en glissement annuel au T2...", etc.]

-

LLM : Le LLM traite ces informations combinées et génère une réponse cohérente et humaine. Par exemple : "Nos revenus du T2 en Europe étaient de 5,4 millions d'euros, ce qui représente une croissance de 15% d'une année sur l'autre."

En fournissant ce contexte spécifique et fondé, le LLM est beaucoup moins susceptible d'"halluciner" ou d'inventer des faits. Sa réponse est désormais basée sur vos données, ce qui la rend fiable et digne de confiance.

-

Objectif : Combiner la requête de l'utilisateur avec le contexte récupéré et le fournir à un LLM pour générer une réponse finale et précise.

Conclusion : La Puissance d'un Pipeline Bien Huilé

Le pipeline RAG est un moteur puissant qui transforme des documents statiques en une source de connaissances dynamique et conversationnelle. En mélangeant de manière transparente la récupération d'informations spécifiques avec la puissance générative des LLM, il offre le meilleur des deux mondes : la précision et l'intelligence.

Comprendre cette anatomie est la clé pour construire des applications d'IA puissantes. Chez [Nom de votre startup SaaS RAG], nous avons perfectionné ce pipeline, en fournissant une plateforme robuste et évolutive pour que vous puissiez déployer de puissantes solutions RAG sans tracas. Prêt à mettre vos données au travail ? Contactez-nous !