De kernuitdaging van privacy in RAG

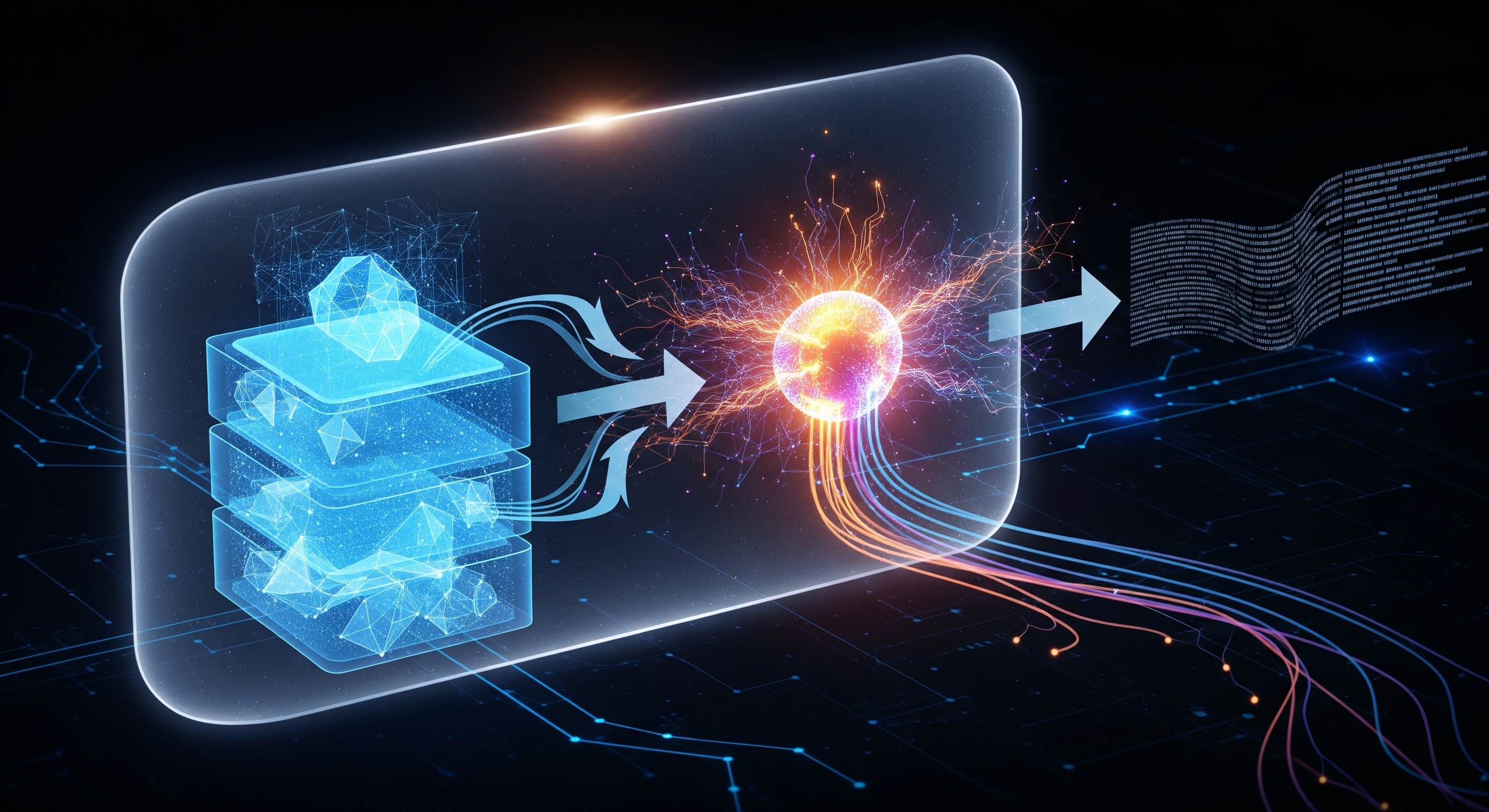

Een standaard RAG-pipeline omvat verschillende stadia: het inlezen (ingestie) van uw documenten, het opdelen ervan, het creëren van numerieke representaties (embeddings), het opslaan in een vectordatabase, en het vervolgens gebruiken van deze data bij een zoekopdracht om context te bieden aan een LLM.

Elke stap brengt een potentieel privacyrisico met zich mee:

-

Data-ingestie en -opslag: Waar worden uw ruwe data bewaard? Wie heeft er toegang toe? Worden ze versleuteld, zowel tijdens overdracht (in transit) als in opslag (at rest)?

-

Het embeddingproces: Worden uw gevoelige documenten naar een externe API gestuurd voor het aanmaken van embeddings? Dit kan de ruwe tekst blootstellen aan een externe leverancier.

-

De vectordatabase: Hoewel embeddings numerieke representaties zijn en geen ruwe tekst, kunnen ze soms worden terugontworpen. De relatie tussen vectoren kan ook informatie lekken.

-

De generatiestap: Wanneer een gebruiker een vraag stelt, welke data wordt dan naar de LLM gestuurd? Zijn dit alleen de relevante fragmenten, of meer? Bewaart de LLM-provider deze gegevens?

Het aanpakken van deze uitdagingen vereist meer dan alleen beloften; het vereist een transparante, verifieerbare en robuuste architectuur.

Onze blauwdruk: Een privacybeschermende RAG-pipeline

Onze architectuur is gebouwd op de principes van "zero-trust" en "privacy by design". We gaan uit van geen impliciet vertrouwen en zorgen ervoor dat elk component en proces expliciet is ontworpen om uw gegevens te beschermen.

Laten we onze pipeline component voor component doorlopen.

1. Data-ingestie en -segmentatie: Uw data, uw omgeving

Vanaf de allereerste stap garanderen we de soevereiniteit van uw gegevens. Onze oplossing integreert rechtstreeks met uw beveiligde databronnen (zoals S3, Google Drive of SharePoint) met behulp van veilige, kortstondige authenticatietokens.

Cruciaal is dat de initiële verwerking – het opdelen van documenten in beheersbare stukken – plaatsvindt in een veilige, geïsoleerde omgeving die exclusief voor u is. Uw ruwe documenten worden nooit permanent opgeslagen op onze primaire systemen. Ze worden in-memory verwerkt en onmiddellijk verwijderd na segmentatie en embedding, in lijn met het principe van dataminimalisatie.

2. De embeddingfase: In eigen huis en onder controle

Dit is een van de meest kritieke knooppunten voor privacy. Veel RAG-providers vertrouwen op externe, black-box embeddingmodellen (bv. van OpenAI of Cohere). Dit betekent dat uw bedrijfseigen data over het internet naar een derde partij wordt gestuurd, waar u de controle over het gebruik en de bewaring ervan verliest.

Wij doen het anders. We maken gebruik van state-of-the-art, open-source embeddingmodellen die binnen onze eigen beveiligde infrastructuur worden gehost. Dit betekent dat uw data nooit naar een externe AI-provider wordt gestuurd voor embedding. Wij beheren het volledige proces en garanderen een veilige en vertrouwelijke transformatie van uw tekstfragmenten naar vectorembeddings.

Het proces ziet er als volgt uit:

Documentfragment (Tekst) rightarrow Beveiligd embeddingmodel van [Naam van uw startup] rightarrow Vectorembedding (bv. een 1024-dimensionale vector vinmathbbR1024)

Deze self-hosted aanpak garandeert niet alleen privacy, maar stelt ons ook in staat om modellen specifiek af te stemmen op de soorten documenten waarmee u werkt, wat de relevantie verbetert zonder de veiligheid in gevaar te brengen.

3. De vector store: Versleuteld en geïsoleerd

Zodra de vectorembeddings zijn gemaakt, worden ze opgeslagen in onze gespecialiseerde vectordatabase. We zorgen hier voor robuuste beveiliging via meerdere lagen:

-

Strikte scheiding van klantdata (Tenant Isolation): Uw data worden opgeslagen in een logisch en fysiek geïsoleerde database-instance. Er is geen mogelijkheid tot kruisbesmetting tussen klantgegevens.

-

Versleuteling in opslag (at rest): Alle gegevens in de vectordatabase, inclusief de vectoren en de bijbehorende metadata, zijn versleuteld met de AES-256-standaard.

-

Versleuteling tijdens overdracht (in transit): Alle communicatie tussen onze applicatieservices en de vectordatabase is beveiligd met TLS 1.3.

4. De RAG-cyclus: Geanonimiseerd en tijdelijk

Wanneer een gebruiker een zoekopdracht indient, voert ons systeem de "retrieval"-stap uit, waarbij de meest relevante datafragmenten uit uw vector store worden gevonden. Zo beschermen we uw privacy tijdens de laatste, kritieke "generatie"-stap:

-

Alleen contextuele fragmenten: We sturen alleen de opgehaalde, relevante tekstfragmenten als context naar de LLM – nooit de volledige documenten van de gebruiker.

-

LLM-onafhankelijkheid en anonimisering: We werken samen met toonaangevende LLM-providers die een strikt beleid hanteren waarbij geen data wordt bewaard of gebruikt voor training. Voordat we het verzoek verzenden, kunnen we een extra laag anonimisering toepassen op de fragmenten, waarbij persoonsgegevens waar nodig worden verwijderd.

-

Contractuele garanties op API-niveau: We hebben robuuste contractuele overeenkomsten met onze LLM-providers die hen wettelijk verbieden uw zoekopdrachten op te slaan of te gebruiken om hun modellen te trainen. De data die voor generatie worden verzonden, zijn efemeer en bestaan alleen voor de duur van de inferentie-aanroep.

Meer dan de pipeline: Holistische beveiliging

Een veilige pipeline is slechts zo sterk als de omgeving waarin deze opereert. Onze toewijding aan uw vertrouwen strekt zich uit over ons hele platform:

-

Strikt toegangsbeheer: We hanteren op rollen gebaseerd toegangsbeheer (RBAC) op ons hele platform, zodat alleen geautoriseerde personen binnen uw organisatie toegang hebben tot specifieke datasets.

-

Uitgebreide auditing: We bieden gedetailleerde auditlogs, zodat u een transparant en onveranderlijk overzicht heeft van wie wat en wanneer heeft geraadpleegd.

-

Klaar voor compliance: Onze architectuur is ontworpen om te voldoen aan en de normen te overtreffen van belangrijke compliance-kaders zoals SOC 2 Type II en de AVG (GDPR).

De essentie: Uw concurrentievoordeel is veilig bij ons

In het tijdperk van AI zijn uw data uw meest waardevolle bezit. Het is uw institutionele kennis, uw unieke marktinzichten en uw concurrentievoordeel.

Door een RAGaaS-provider te kiezen, koopt u niet zomaar een stuk technologie; u gaat een partnerschap aan dat is gebouwd op vertrouwen. Onze privacy-first architectuur is onze belofte aan u dat uw data beschermd zullen worden, uw privacy gerespecteerd zal worden en uw concurrentievoordeel veilig van u zal blijven.