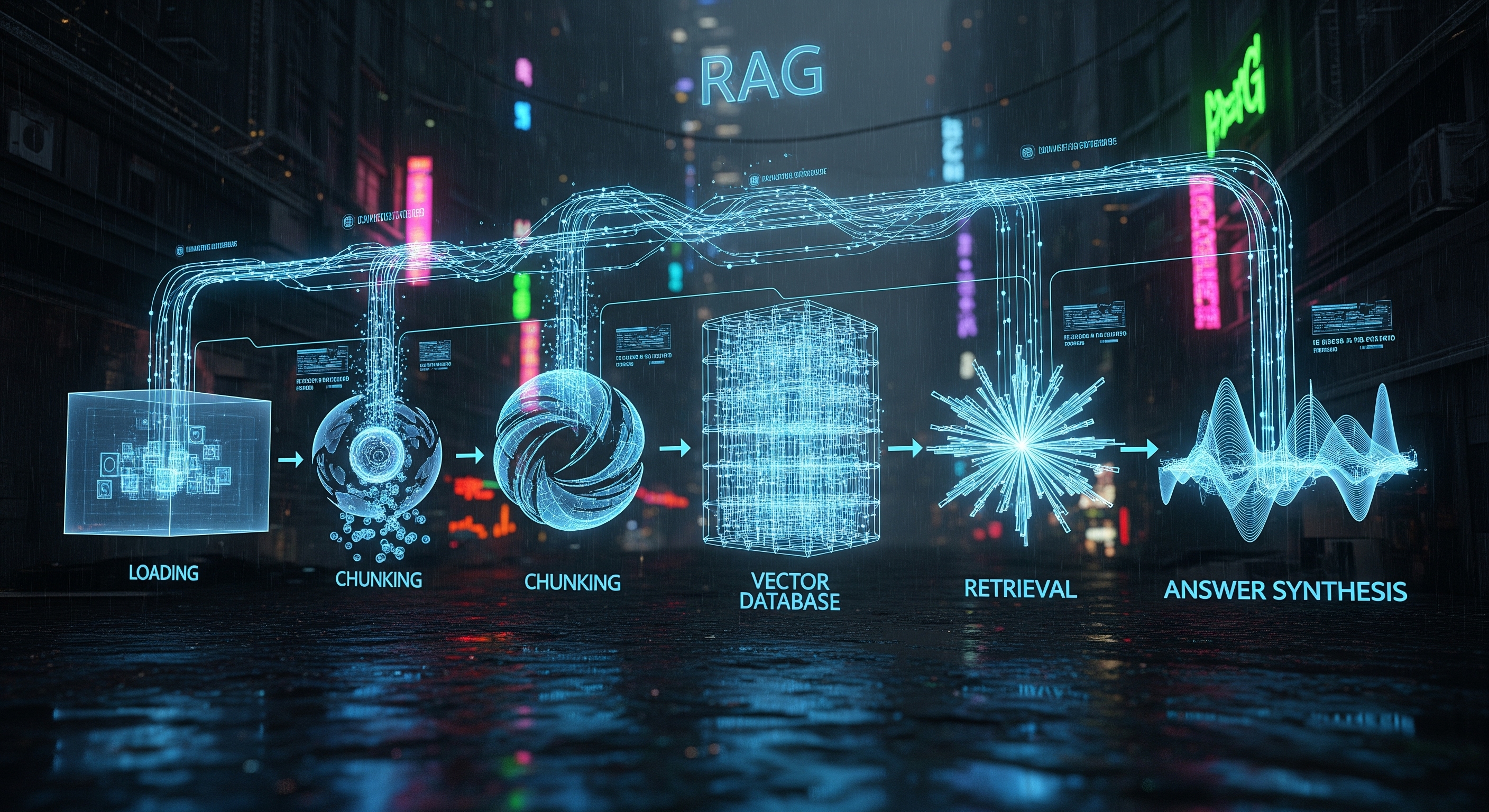

Fase 1: Laden en Opdelen (Loading and Chunking) 쪼개기

Allereerst moet u uw data in het systeem invoeren. Dit is de laadfase. De data kan overal vandaan komen: pdf's, Word-documenten, websites, een Notion-database of zelfs een Slack-kanaal. De pipeline neemt deze ongestructureerde, ruwe data op.

LLM's hebben echter een beperkt contextvenster — ze kunnen slechts een bepaalde hoeveelheid informatie tegelijk verwerken. U kunt niet zomaar een handleiding van 500 pagina's in de prompt plakken. Dat is waar het opdelen (chunking) van pas komt. De geladen data wordt strategisch opgesplitst in kleinere, beheersbare stukken of "chunks". Dit is niet zomaar willekeurig hakwerk; effectief opdelen behoudt de semantische betekenis van de tekst, vaak door deze op te splitsen in paragrafen of secties.

-

Doel: Ruwe data opnemen en opdelen in betekenisvolle, behapbare stukken voor verwerking.

Fase 2: De Indexeringsfase: Welkom, Vectordatabases! 🗂️

Zodra uw data is opgedeeld, heeft het systeem een manier nodig om deze te begrijpen en te organiseren. Dit is de indexeringsfase, en hier wordt de "vector" in "vectordatabase" cruciaal.

Elk stuk tekst wordt omgezet in een numerieke representatie, een zogenaamde vector embedding. Zie dit als een geavanceerde digitale vingerafdruk. Een embeddingmodel (een gespecialiseerd neuraal netwerk) leest een stuk tekst en legt de semantische betekenis vast als een lijst van getallen (een vector). Stukken tekst met vergelijkbare betekenissen zullen vectoren hebben die wiskundig gezien "dicht" bij elkaar liggen.

Deze vectoren worden vervolgens opgeslagen in een gespecialiseerde database die precies voor dit doel is ontworpen: een vectordatabase. Deze database is sterk geoptimaliseerd om miljoenen of zelfs miljarden van deze vectoren op te slaan en razendsnel te doorzoeken.

-

Doel: Tekststukken omzetten in numerieke vectoren (embeddings) en deze opslaan in een doorzoekbare vectordatabase.

Fase 3: De Ophaalfase: De Juiste Context Vinden 🔍

Stel nu dat u een vraag stelt, zoals: "Wat was onze omzet in Q2 in Europa?" Dit is waar de "Retrieval" (Ophalen) in RAG in actie komt.

Uw vraag wordt ook omgezet in een vector embedding met behulp van hetzelfde model. Het RAG-systeem gebruikt deze vraagvector vervolgens om de vectordatabase te doorzoeken. Het voert een gelijkeniszoekopdracht (similarity search) uit (vaak met een algoritme zoals Cosine Similarity) om de tekststukken te vinden waarvan de vectoren het dichtst bij de vector van uw vraag liggen.

Het resultaat is een gerangschikte lijst van de meest relevante stukken tekst uit uw oorspronkelijke documenten. Dit zijn niet alleen trefwoordmatches; het zijn stukken die semantisch gerelateerd zijn aan uw vraag. Dit is de cruciale context die het LLM nodig heeft om een precies antwoord te formuleren.

-

Doel: De vraag van de gebruiker omzetten in een vector en de meest relevante informatie uit de vectordatabase ophalen.

Fase 4: De Synthesefase: Het Eindantwoord Genereren ✨

Met de meest relevante context opgehaald, zijn we bij de laatste fase: antwoordsynthese.

De RAG-pipeline neemt uw oorspronkelijke vraag en de opgehaalde tekststukken en bundelt ze in een nieuwe, verrijkte prompt voor het LLM. De prompt zegt in wezen: "Gebruik de volgende informatie om deze vraag te beantwoorden."

-

Oorspronkelijke vraag: "Wat was onze omzet in Q2 in Europa?"

-

Opgehaalde context: [Stuk 1: "Het financiële verslag van Q2 toont een Europese omzet van €5,4 miljoen...", Stuk 2: "Samenvatting van de Europese activiteiten benadrukt een groei van 15% j-o-j in Q2...", etc.]

-

LLM: Het LLM verwerkt deze gecombineerde informatie en genereert een coherent, menselijk antwoord. Bijvoorbeeld: "Onze omzet in Q2 in Europa was €5,4 miljoen, wat een groei van 15% op jaarbasis vertegenwoordigt."

Door deze specifieke, gefundeerde context te bieden, is de kans veel kleiner dat het LLM "hallucineert" of feiten verzint. Het antwoord is nu gebaseerd op uw data, wat het betrouwbaar en geloofwaardig maakt.

-

Doel: De vraag van de gebruiker combineren met de opgehaalde context en dit aan een LLM voeren om een definitief, accuraat antwoord te genereren.

Conclusie: De Kracht van een Goed Geoliede Pipeline

De RAG-pipeline is een krachtige motor die statische documenten omzet in een dynamische, conversationele kennisbron. Door de naadloze combinatie van het ophalen van specifieke informatie met de generatieve kracht van LLM's, biedt het het beste van twee werelden: nauwkeurigheid en intelligentie.

Het begrijpen van deze anatomie is de sleutel tot het bouwen van krachtige AI-toepassingen. Hier bij [Naam van uw RAG SaaS Startup] hebben we deze pipeline geperfectioneerd en bieden we een robuust en schaalbaar platform zodat u krachtige RAG-oplossingen kunt implementeren zonder gedoe. Klaar om uw data aan het werk te zetten? Neem contact met ons op!